Die Rolle von Künstlicher Intelligenz (KI) und Maschinellem Lernen (ML) im modernen DevOps Ansatz

Die Rolle von Künstlicher Intelligenz (KI) und Maschinellem Lernen (ML) im modernen DevOps Ansatz

In der heutigen schnelllebigen Technologielandschaft stehen Unternehmen vor der

Herausforderung, ihre Softwareentwicklungs- und Bereitstellungsprozesse kontinuierlich zu

optimieren. Die Integration von Künstlicher Intelligenz (KI) und Maschinellem Lernen (ML) in

DevOps hat sich dabei als entscheidender Faktor erwiesen, um Automatisierung zu verbessern,

Vorhersagen zu treffen und die Effizienz zu steigern.

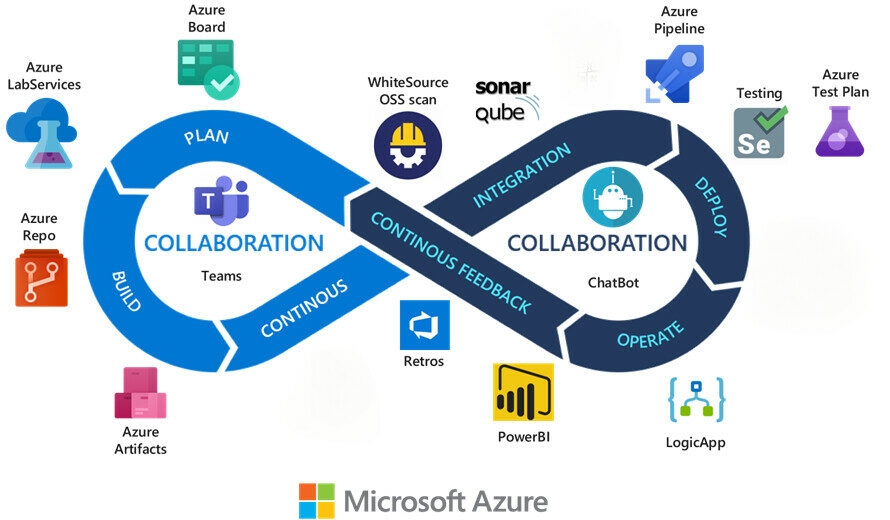

Integration von KI/ML in DevOps

Wenn man DevOps mit einem Uhrwerk vergleicht, dann sind KI und ML wie ein automatischer

Uhrmacher: Sie greifen dort ein, wo vorher manuelles Eingreifen nötig war, und das mit Präzision,

Geschwindigkeit und manchmal mit überraschender Weitsicht. Durch den Einsatz trainierter Modelle

können Logdateien in Echtzeit analysiert, Anomalien automatisch erkannt und mögliche Ursachen

eingegrenzt werden, noch bevor ein Mensch überhaupt eingreift. Aber damit nicht genug: KI kann

auch Prioritäten setzen, Risiken bewerten und Vorschläge machen, wie ein Deployment verbessert

oder beschleunigt werden könnte. Der Übergang vom reaktiven zum proaktiven DevOps wird durch

diese Technologien erst möglich.

Fallstudie: Uniphore

Ein Beispiel aus der Praxis verdeutlicht das besonders gut: Das Unternehmen Uniphore, bekannt für

seine KI-gesteuerten Lösungen im Bereich Sprach- und Gesprächsanalytik hatte sich das Ziel

gesetzt, Innovationen schneller zum Kunden zu bringen, ohne dabei Abstriche bei Sicherheit oder

Zuverlässigkeit zu machen. Mithilfe der DevSecOps-Automatisierungsplattform von DuploCloud und

der Infrastruktur von AWS gelang es Uniphore, eine agile Umgebung zu schaffen,

in der neue Produktfeatures in einem Bruchteil der früher benötigten Zeit ausgeliefert werden

konnten. Die operative Komplexität sank drastisch um ganze 70 Prozent, während sich die

Time-to-Value für neue Lösungen fast verzehnfachte. Dieses Beispiel zeigt: Wenn Technologie auf

eine klare Vision trifft, sind transformative Ergebnisse möglich.

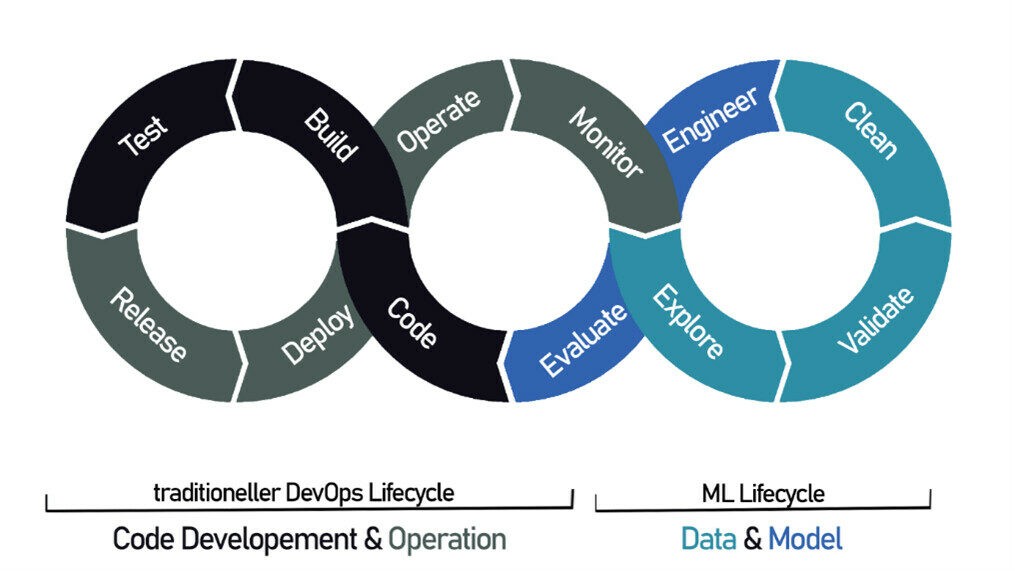

MLOps vs. DevOps

MLOps wird häufig als DevOps für maschinelles Lernen bezeichnet, und dem kann man nur schwer widersprechen. MLOps erbt viele Prinzipien von DevOps.

Trotz der Ähnlichkeit können wir nicht einfach DevOps-Tools nehmen und sie auf die Operationalisierung von ML-Modellen anwenden. Und hier sind die Hauptgründe dafür.

1. Neben der Code-Versionierung benötigen wir einen Speicherort für Daten und Modellversionen.

Beim maschinellen Lernen wird viel experimentiert. Datenwissenschaftler trainieren Modelle mit verschiedenen Datensätzen, was zu unterschiedlichen Ergebnissen führt. Zusätzlich zur in DevOps verwendeten Code-Versionskontrolle benötigt MLOps daher spezielle Instrumente zum Speichern von Daten und Modellversionen, die wiederverwendet und neu trainiert werden können.

2. Im Gegensatz zu Code verschlechtern sich Modelle mit der Zeit, was eine Überwachung erfordert .

Nachdem ein trainiertes Modell in die Produktion gelangt ist, beginnt es, Vorhersagen aus realen Daten zu generieren. In einer stabilen Umgebung würde seine Genauigkeit nie nachlassen. Aber leider „verändern sich das Leben und damit auch die Live-Daten, die unser Modell aufnimmt,“ – räumt ein erfahrener Entwickler ein. „Dies führt zu einer sogenannten Modellverschlechterung – mit anderen Worten, seine Vorhersageleistung nimmt mit der Zeit ab. Um Fehler zu vermeiden, brauchen wir eine kontinuierliche Modellüberwachung, was für DevOps-Praktiken nicht typisch ist.“

3. Das Training endet nie.

Sobald der Leistungsabfall erkannt wird, muss das Modell mit den neuen Daten neu trainiert und validiert werden, bevor es wieder in die Produktion eingeführt wird. Bei MLOps ersetzen kontinuierliches Training und Validierung kontinuierliche Tests, die bei DevOps durchgeführt werden.

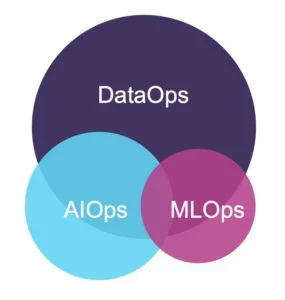

MLOps vs. DataOps

DataOps oder Data Operations kamen fast zeitgleich mit MLOps ins Spiel und haben sich auch viele Muster von DevOps entlehnt. Der Kernbereich der Anwendung ist jedoch die Datenanalyse.

DataOps deckt alle Schritte des Datenlebenszyklus ab, von der Erfassung bis zur Analyse und Berichterstattung, und automatisiert sie, wo immer möglich. Ziel ist es, die Qualität und Zuverlässigkeit von Daten zu verbessern und gleichzeitig die für die Bereitstellung einer Analyselösung erforderliche Zeit zu minimieren.

Der Ansatz ist besonders hilfreich für Organisationen, die mit grossen Datensätzen und komplexen Datenpipelines arbeiten. DataOps kann auch ML-Projekte erleichtern – allerdings nur bis zu einem gewissen Grad, da es keine Lösungen für die Verwaltung eines Modelllebenszyklus bietet. MLOps kann also als Erweiterung von DataOps betrachtet werden.

MLOps vs. AIOps

AIOps, die jüngste der oben genannten Operations, wird oft synonym mit MLOps verwendet, was, vereinfacht ausgedrückt, nicht korrekt ist. Laut Gartner, der den Begriff 2017 geprägt hat, „kombiniert AIOps – oder Artificial Intelligence for IT Operations – Big Data und maschinelles Lernen, um IT-Betriebsprozesse zu automatisieren.“

Im Wesentlichen besteht das Ziel von AIOps darin, Probleme im täglichen IT-Betrieb automatisch zu erkennen und mithilfe von KI proaktiv darauf zu reagieren. Gartner geht davon aus, dass bis 2025 bis zu 30 Prozent der grossen Unternehmen AIOps-Tools zur Überwachung ihrer IT-Systeme einsetzen werden.

Und nun ist es an der Zeit, zu unserem Kernthema zurückzukehren und den gesamten MLOps-Zyklus genauer zu untersuchen.

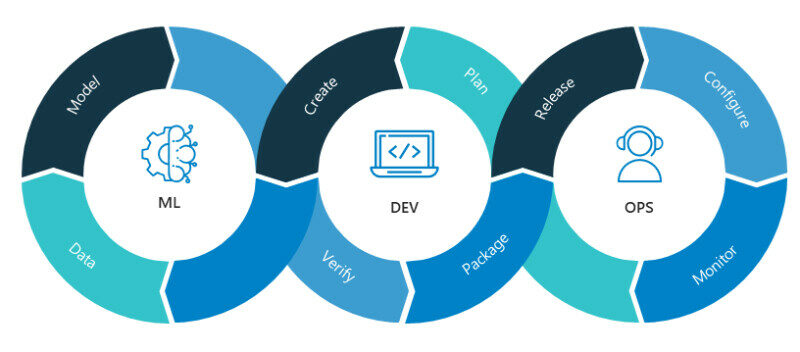

MLOps-Konzepte und -Workflow

Der durchgängige MLOps-Workflow wird durch kontinuierliche Integrations-, Bereitstellungs- und Schulungsmethoden gesteuert, die sich gegenseitig ergänzen und den Weg von KI-Lösungen zu den Kunden verkürzen.

Continuous Integration und Continuous Delivery (CI/CD).

MLOps ist in einem CI/CD-Rahmen angesiedelt, der von DevOps als bewährte Methode zur Einführung hochwertiger Code-Updates in kurzen Abständen befürwortet wird. Beim maschinellen Lernen wird die Integrationsphase jedoch um die Daten- und Modellvalidierung erweitert, während bei der Bereitstellung die Komplexität von maschinellen Lernbereitstellungen berücksichtigt wird. Insgesamt führt CI/CD Daten-, Modell- und Codekomponenten zusammen, um einen prädiktiven Dienst zu veröffentlichen und zu aktualisieren.

Continuous Training (CT).

Ein einzigartiges Konzept für MLOps, bei dem es um die Automatisierung des Modell-Retrainings geht. Es umfasst alle Schritte des Modell-Lebenszyklus von der Datenerfassung bis zur Leistungsüberwachung in der Produktion. CT stellt sicher, dass Ihr Algorithmus bei den ersten Anzeichen von Verfall oder Veränderungen in der Umgebung aktualisiert wird.

Um besser zu verstehen, wie kontinuierliche Integration, Bereitstellung und Schulung in der Praxis umgesetzt werden und wie die Aufgaben zwischen ML- und Betriebsspezialisten aufgeteilt werden, wollen wir uns die Schlüsselkomponenten von MLOps in einem nächsten Beitrag näher ansehen. Dazu gehören:

- Modell-Trainings-Pipeline

- Modellregister

- Modellbereitstellung (Deployment)

- Modellüberwachung

- CI/CD-Orchestrierung

Natürlich können die Schritte und der gesamte Workflow in verschiedenen Fällen variieren – je nach Projekt, Unternehmensgrösse, Geschäftsaufgaben, Komplexität des maschinellen Lernens und anderen Faktoren.

Mit dem Fortschreiten der Technologie ist zu erwarten, dass KI und ML eine noch zentralere Rolle in

DevOps einnehmen werden. Die Entwicklung von MLOps, einer Praxis zur Operationalisierung von

ML-Modellen, wird weiter voranschreiten und Unternehmen dabei unterstützen, ihre Modelle

effizient zu verwalten und zu skalieren.

Natürlich bringt jede technologische Neuerung auch ihre Schattenseiten mit sich. KI und ML sind

Keine Selbstläufer, sie leben von Daten. Und Daten, insbesondere im DevOps-Umfeld, sind oft

verstreut, inkonsistent oder sensibel. Damit ein Algorithmus lernen kann, braucht er nicht nur grosse

Mengen, sondern vor allem qualitativ hochwertige Informationen. Genau hier beginnen die

Herausforderungen: Datenschutzrichtlinien, Governance-Fragen und ethische Abwägungen stehen

jeder Innovation gegenüber. Zudem stellt sich die Frage: Wie viel Entscheidungsmacht wollen wir

Maschinen wirklich überlassen, gerade bei sicherheitsrelevanten Prozessen? Diese Bedenken sind

nicht neu, aber sie verdienen besondere Beachtung, wenn man mit KI im produktiven Betrieb

arbeitet.

Die Reise hat gerade erst begonnen. Während heute viele Unternehmen noch in der Pilot- oder

Experimentierphase stecken, zeichnen sich schon klare Trends ab: MLOps also die

Operationalisierung von ML-Modellen wird zum neuen Goldstandard. Ähnlich wie DevOps eine

Brücke zwischen Entwicklung und IT-Betrieb gebaut hat, schlägt MLOps die Verbindung zwischen

Datenwissenschaft und Produktionsumgebung. Künftig könnten adaptive Systeme in Echtzeit auf

Umgebungsdaten reagieren, sich selbst kalibrieren und mit DevOps-Pipelines harmonieren.

Vielleicht erleben wir schon bald eine Ära, in der menschliche und künstliche Intelligenz nicht mehr

getrennt, sondern als kollaborative Einheit gedacht wird.

Wie seht ihr diese spannende Entwicklung? Schreibt Eure Meinung gerne in die Kommentare.

LG Euer Sven